1°Das clic en inicio.

1° Das clic en inicio.

2° despues ejecutar

3°Escriiibes control.

4°Y por ultimo aceptar.

| La Fuente de Alimentación, es un montaje eléctrico/electrónico capaz de transformar la corriente de la red electrica en una corriente que el pc pueda soportar. Esto se consigue a través de unos procesos electrónicos los cuales explicaremos brevemente. |

|

| 1. Transformación. Este paso es en el que se consigue reducir la tensión de entrada a la fuente (220v o 125v) que son los que nos otorga la red eléctrica. Esta parte del proceso de transformación, como bien indica su nombre, se realiza con un transformador en bobina. La salida de este proceso generará de 5 a 12 voltios. 2. Rectificación. La corriente que nos ofrece la compañía eléctrica es alterna, esto quiere decir, que sufre variaciones en su linea de tiempo, con variaciones, nos referimos a variaciones de voltajes, por tanto, la tensión es variable, no siempre es la misma. Eso lógicamente, no nos podría servir para alimentar a los componentes de un PC, ya que imaginemos que si le estamos dando 12 voltios con corriente alterna a un disco duro, lógicamente no funcionará ya que al ser variable, no estariamos ofreciendole los 12 voltios constantes. Lo que se intenta con esta fase, es pasar de corriente alterna a corriente continua, a través de un componente que se llama puente rectificador o de Graetz. Con esto se logra que el voltaje no baje de 0 voltios, y siempre se mantenga por encima de esta cifra. 3. Filtrado Ahora ya, disponemos de corriente continua, que es lo que nos interesaba, no obstante, aun no nos sirve de nada, porque no es constante, y no nos serviría para alimentar a ningun circuito Lo que se hace en esta fase de filtrado, es aplanar al máximo la señal, para que no hayan oscilaciones, se consigue con uno o varios condensadores, que retienen la corriente y la dejan pasar lentamente para suavizar la señal, así se logra el efecto deseado. 4. Estabilización Ya tenemos una señal continua bastante decente, casi del todo plana, ahora solo nos falta estabilizarla por completo, para que cuando aumenta o descienda la señal de entrada a la fuente, no afecte a la salida de la misma. Esto se consigue con un regulador. Tipos de Fuentes Después de comentar estas fases de la fuente de alimentación, procederemos a diferenciar los dos tipos que existen actualmente. Las dos fuentes que podremos encontrarnos cuando abramos un ordenador pueden ser: AT o ATX Las fuentes de alimentación AT, fueron usadas hasta que apareció el Pentium MMX, es en ese momento cuando ya se empezarían a utilizar fuentes de alimentación ATX. Las características de las fuentes AT, son que sus conectores a placa base varían de los utilizados en las fuentes ATX, y por otra parte, quizás bastante más peligroso, es que la fuente se activa a través de un interruptor, y en ese interruptor hay un voltaje de 220v, con el riesgo que supondría manipular el PC. También destacar que comparadas tecnológicamente con las fuentes ATX, las AT son un tanto rudimentarias electrónicamente hablando. En ATX, es un poco distinto, ya que se moderniza el circuito de la fuente, y siempre está activa, aunque el ordenador no esté funcionando, la fuente siempre está alimentada con una tensión pequeña para mantenerla en espera. Una de las ventajas es que las fuentes ATX no disponen de un interruptor que enciende/apaga la fuente, si no que se trata de un pulsador conectado a la placa base, y esta se encarga de encender la fuente, esto conlleva pues el poder realizar conexiones/desconexiones por software. Existe una tabla, para clasificar las fuentes según su potencia y caja. Sobremesa AT => 150-200 W Semitorre => 200-300 W Torre => 230-250 W Slim => 75-100 W Sobremesa ATX => 200-250 W No obstante, comentar, que estos datos son muy variables, y unicamente son orientativos, ya que varía segun el numero de dispositivos conectados al PC. Conexión de Dispositivos En Fuentes AT, se daba el problema de que existian dos conectores a conectar a placa base, con lo cual podia dar lugar a confusiones y a cortocircuitos, la solución a ello es basarse en un truco muy sencillo, hay que dejar en el centro los cables negros que los dos conectores tienen, asi no hay forma posible de equivocarse. |

|

| En cambio, en las fuentes ATX solo existe un conector para la placa base, todo de una pieza, y solo hay una manera de encajarlo, así que por eso no hay problema |

|

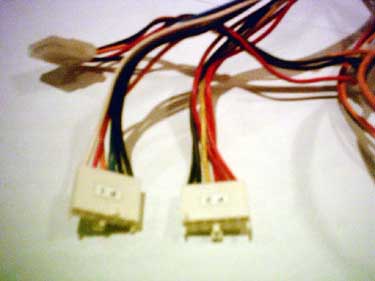

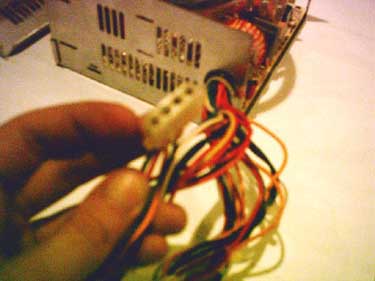

| Existen dos tipos de conectores para alimentar dispositivos: El más grande, sirve para conectar dispositivos como discos duros, lectores de cd-rom, grabadoras, dispositivos SCSI, etc... |

|

| Mientras que el otro, visiblemente más pequeño, sirve para alimentar por ejemplo disqueteras o algunos dispositivos ZIP. Instalación de una fuente ATX Para instalar una fuente de alimentación ATX, necesitaremos un destornillador de punta de estrella. Empezaremos por ubicar la fuente en su sitio, asegurando que los agujeros de los tornillos, coinciden exactamente con los de la caja. Una vez hecho esto, procederemos a atornillar la fuente. Acto seguido, conectaremos la alimentación a la placa base con el conector anteriormente comentado, y realizaremos la misma tarea con el resto de los dispositivos instalados. Un punto a comentar, es que solo hay una manera posible para realizar el conexionado de alimentación a los dispositivos, sobretodo, NUNCA debemos forzar un dispositivo. Tras realizar todas las conexiones, las revisaremos, y procederemos a encender el equipo. Consejos Cuidado con tocar el interruptor selector de voltaje que algunas fuentes llevan, este interruptor sirve para indicarle a la fuente si nuestra casa tiene corriente de 220v o 125v si elegimos la que no es tendremos problemas. Es conveniente, revisar de tanto en tanto, el estado del ventilador de la fuente, hay que pensar, que si no tenemos instalado en la parte posterior del equipo un ventilador adicional, es nuestra única salida de aire. Un ventilador de fuente defectuoso puede significar el final de tu equipo, elevando la temperatura del sistema por encima de la habitual y produciendo un fallo general del sistema. |

|

| También cabe destacar, en como elegir la fuente, si tenemos pensado de conectar muchos dispositivos, como por ejemplo, dispositivos USB, discos duros, dispositivos internos, etc... En el caso de que la fuente no pueda otorgar la suficiente tensión para alimentar a todos los dispositivos, se podrían dar fallos en algunos de los mismos, pero pensar que si estamos pidiendo más de lo que nos otorga la fuente, podemos acabar con una placa base quemada, una fuente de alimentación quemada, un microprocesador quemado, y un equipo flamante en la basura... |